DeepSeek AI en local : Comment exécuter une IA sur votre machine

L'intégration d'une intelligence artificielle en local sur sa machine est une solution idéale pour les développeurs souhaitant éviter les limitations des API cloud, réduire les coûts ou simplement garder le contrôle de leurs données. Cet article vous guide pas à pas pour installer et exécuter un modèle d'IA en local, en prenant l'exemple de DeepSeek.

Pourquoi faire tourner une IA en local ?

Héberger une IA sur sa propre machine présente plusieurs avantages :

- Confidentialité des données : vos interactions ne quittent pas votre environnement.

- Performance et latence réduite : pas d'attente due aux requêtes réseau.

- Coût réduit : évitez les abonnements aux services cloud.

- Personnalisation : adaptez l'IA à vos besoins spécifiques.

Prérequis pour l'installation de DeepSeek

Avant de commencer, assurez-vous d'avoir :

- Un PC avec une carte graphique NVIDIA (DeepSeek exploite CUDA pour accélérer le calcul sur GPU).

- Python 3.8+ installé.

- Git et un environnement virtuel (venv ou conda).

- Au moins 16 Go de RAM (32 Go recommandés pour les modèles volumineux).

Installation de DeepSeek en local

1. Installer les dépendances

Commencez par installer les outils nécessaires :

sudo apt update && sudo apt install -y git python3-pip

pip install --upgrade pip

Si vous utilisez Windows, installez WSL pour profiter d'un environnement Linux.

2. Cloner le répertoire DeepSeek

git clone https://github.com/DeepSeek-AI/DeepSeek.git

cd DeepSeek

3. Créer un environnement virtuel et installer les packages Python

python3 -m venv venv

source venv/bin/activate # Sur Windows : venv\Scripts\activate

pip install -r requirements.txt

4. Télécharger le modèle DeepSeek

DeepSeek propose plusieurs variantes de son modèle, selon vos besoins en performance et en mémoire.

mkdir models

cd models

wget https://deepseek.ai/download/deepseek-large.bin # Exemple avec le modèle Large

Si vous avez un GPU performant, optez pour la version Large. Sinon, utilisez la version Small pour de meilleures performances.

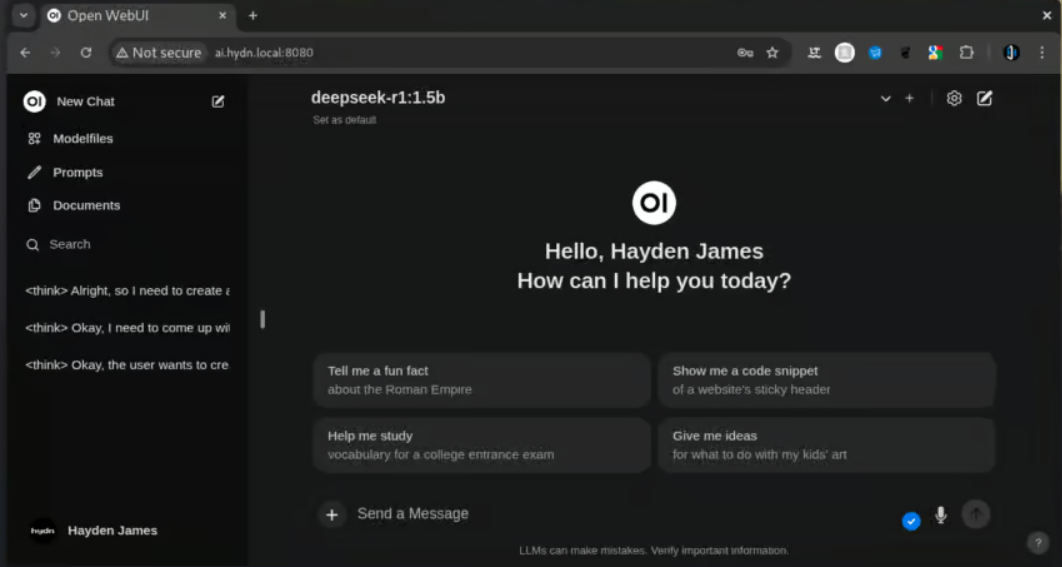

Exécution de l'IA en local

1. Lancer le serveur

Retournez dans le dossier de DeepSeek et démarrez le modèle :

python run.py --model_path=models/deepseek-large.bin --use_gpu

Le serveur d'IA devrait maintenant tourner en local.

2. Tester une requête

Une fois le serveur actif, testez une requête simple :

from deepseek import Client

client = Client("http://localhost:5000")

response = client.ask("Qu'est-ce que DeepSeek ?")

print(response)

Si tout fonctionne, vous devriez obtenir une réponse générée par DeepSeek !

Optimisation et personnalisation

1. Accélérer l'inférence avec TensorRT

Si vous avez un GPU NVIDIA compatible, vous pouvez optimiser DeepSeek avec TensorRT :

pip install tensorrt

python optimize.py --model_path=models/deepseek-large.bin

2. Personnaliser le modèle

DeepSeek permet l'ajout de données spécifiques pour l'adapter à vos besoins :

client.train(custom_dataset="data/my_dataset.json")

Conclusion

En suivant ces étapes, vous avez maintenant une IA fonctionnant en local sur votre machine, sans dépendance aux services cloud. DeepSeek est un excellent point de départ, mais n'hésitez pas à tester d'autres modèles comme Llama 2 ou Mistral selon vos besoins.

Si vous souhaitez aller plus loin, pensez à intégrer votre IA dans une API Flask ou FastAPI pour une utilisation plus flexible.

Bon dev ! 🚀